一家营收千亿美元的公司,如何回应 AI 落地的策略问题

一家营收千亿美元的公司,如何回应 AI 落地的策略问题2025 年 9 月 19 日,亚马逊云科技官宣:Qwen3 和 DeepSeek v3.1,首次上线 Amazon Bedrock ,正式对外提供服务,再一次引起了全球生成式 AI 市场对 Amazon Bedrock 这一产品的关注。

2025 年 9 月 19 日,亚马逊云科技官宣:Qwen3 和 DeepSeek v3.1,首次上线 Amazon Bedrock ,正式对外提供服务,再一次引起了全球生成式 AI 市场对 Amazon Bedrock 这一产品的关注。

在最近的一档脱口秀节目中,演员张俊调侃 DeepSeek 是一款非常「内耗」的 AI,连个「1 加 1 等于几」都要斟酌半天。

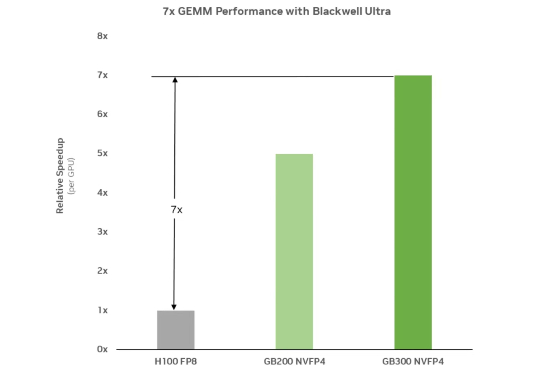

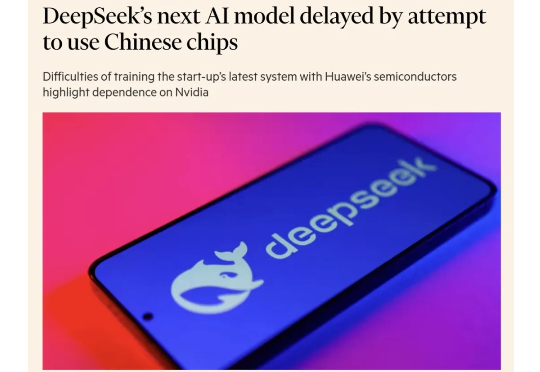

前些天,DeepSeek 在发布 DeepSeek V3.1 的文章评论区中,提及了 UE8M0 FP8 的量化设计,声称是针对即将发布的下一代国产芯片设计。

一早起来,看到群里炸了锅!主角是我们备受期待的 DeepSeek V3.1 模型。有用户反馈,该模型在生成文本时,会毫无征兆地随机插入“极”这个汉字(繁体简体都会)

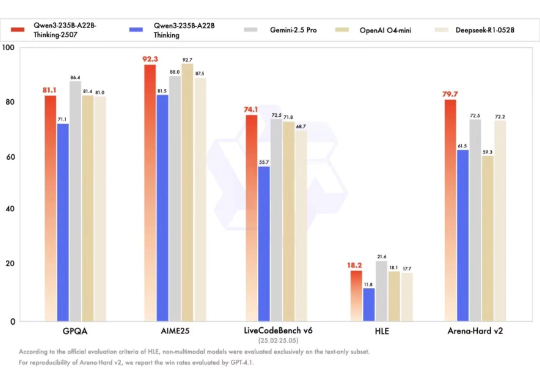

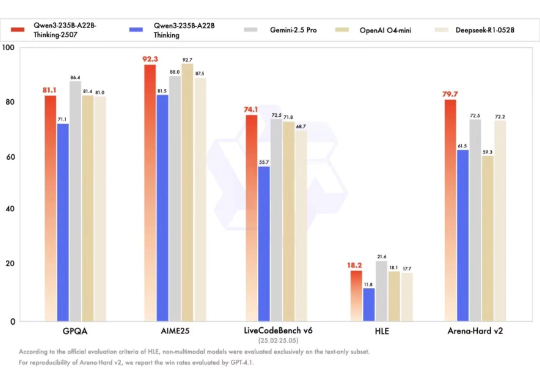

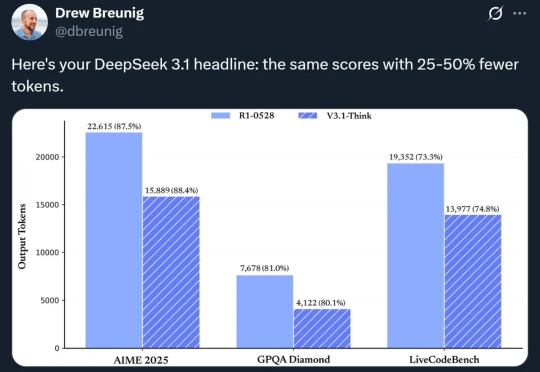

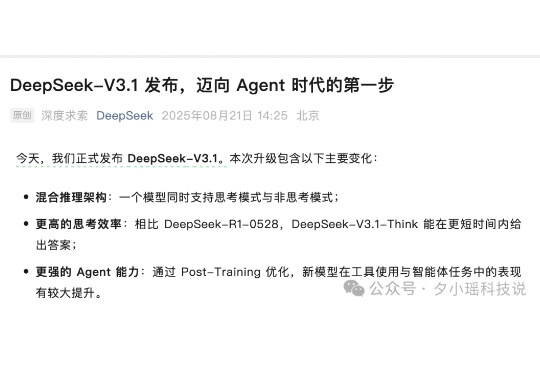

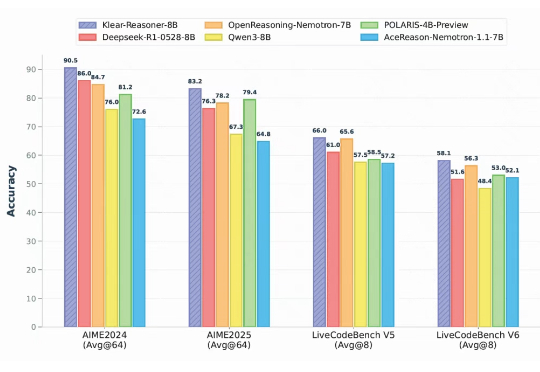

今天下午,DeepSeek 官方正式发布 DeepSeek-V3.1。相比于前天只在用户群里通知,今天新增了模型升级点、榜单成绩、model card,huggingface 上现在也可以下载模型文件了。

在大语言模型的竞争中,数学与代码推理能力已经成为最硬核的“分水岭”。从 OpenAI 最早将 RLHF 引入大模型训练,到 DeepSeek 提出 GRPO 算法,我们见证了强化学习在推理模型领域的巨大潜力。

软件+硬件的全链路国产 AI 体系来了? 这几天,不论国内国外,人们都在关注 DeepSeek 发布的 V3.1 新模型。

这就是我与 HMD 3210 的奇遇记:一台外表是 30 年前诺基亚、内心却住着一个完整大模型的「时光机器」。

2025 年已过半,今年的大模型热度明显下降,关于基础模型的关注大多收敛到了 DeepSeek 与阿里通义上。相比之下,曾一度被标榜为大模型“国产替代”、信创之光的智谱 AI 所受到的关注度明显下降,过往高调的战略打法也渐显低迷。

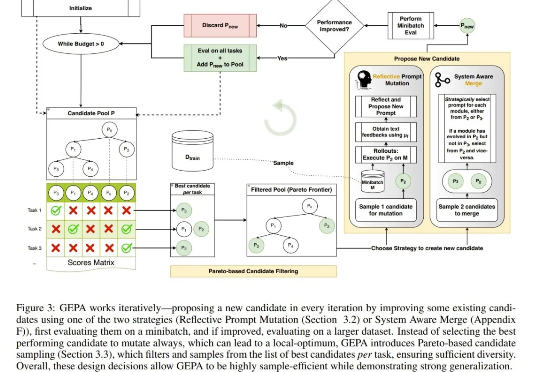

仅靠提示词优化就能超越 DeepSeek 开发的 GRPO 强化学习算法? 是的,你没有看错。近日上线 arXiv 的一篇论文正是凭此吸引了无数眼球。